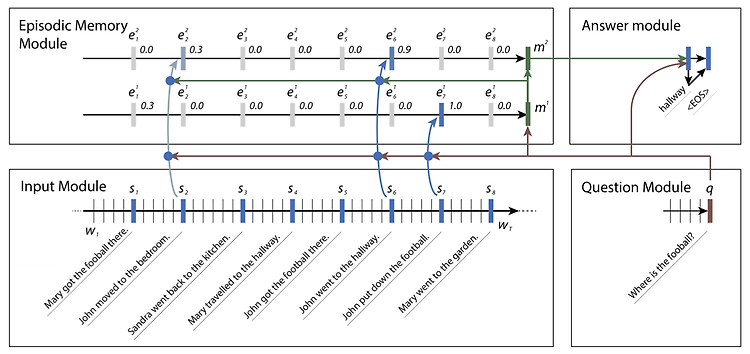

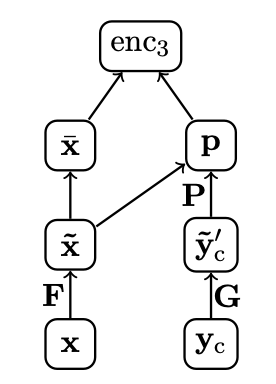

1. Question & Answering Question Answering(QA) task는 말그대로 질문에 대한 대답을 생성하는 NLP task 입니다. QA는 Text에 대한 이해와 사실(fact)에 대한 추론 능력을 모델에게 요구하기 하기 때문에 매우 복잡한 작업 중 하나로 손꼽힙니다. 하지만 머신러닝 알고리즘을 사용하는 이유 자체가 특정 문제(Q)에 대한 해결(A)이라는 관점에서 봤을 때, QA Task는 사실 매우 General한 문제를 다루고 있습니다. 이는 NLP Task에도 동일하게 적용되며, 아래의 예시와 같이 대부분의 NLP Task는 QA Task로 general하게 표현될 수 있습니다. 2. Dynamic Memory Networks 2016년 발표된 본 논문은 general Qu..